Quando l’IA si inventa la verità. Che cosa sono le allucinazioni artificiali

Come ci esponiamo ai rischi di credere in una realtà alternativa — costruita, inconsapevolmente, da un algoritmo

Nel giro di pochi anni, l’intelligenza artificiale generativa è passata dall’essere una novità tecnologica al diventare uno strumento quotidiano per milioni di persone. Tra gli utilizzatori più assidui ci sono gli studenti, che spesso si affidano a chatbot come ChatGPT per riassunti, tesine e perfino per la stesura di interi compiti. Questo uso diffuso ha sollevato interrogativi importanti nel mondo scolastico: quanto possiamo fidarci delle informazioni generate dall’IA?

E soprattutto, cosa accade quando questi strumenti producono contenuti che sembrano veri, ma non lo sono affatto?

Il fenomeno delle “allucinazioni” dell’IA è al centro di queste domande.

Le allucinazioni si verificano quando un modello linguistico, pur sembrando sicuro e preciso, genera dati falsi o affermazioni infondate; si tratta di un problema strutturale, che si manifesta in contesti educativi, sanitari, giuridici e informativi e, più l’IA si inserisce nella nostra quotidianità – dalla scuola alle ricerche su Google – più diventa urgente affrontare questo limite con consapevolezza.

L’intelligenza artificiale ha raggiunto livelli impressionanti nella produzione di linguaggio, con modelli come ChatGPT, Gemini e Claude capaci di scrivere articoli, riassunti e risposte a domande complesse. Tuttavia, proprio quando sembrano più convincenti, questi strumenti rischiano di diventare anche più ingannevoli. Uno dei problemi più inquietanti e dibattuti della moderna IA generativa è quello delle “allucinazioni”: risposte che sembrano fondate, ma che sono in realtà completamente inventate.

Il termine “allucinazione” è entrato nel lessico tecnologico per descrivere quei momenti in cui un modello AI produce un’informazione falsa, pur mantenendo la forma e il tono di un’affermazione credibile. Non si tratta di un semplice errore di battitura o di una svista: è una risposta costruita con sicurezza, ma scollegata dai dati reali o dal contesto.

La portata del problema è emersa chiaramente con la diffusione di chatbot sempre più accessibili.

Ad esempio, Google ha recentemente lanciato la funzione “AI Overviews” nel suo motore di ricerca: un sistema capace di sintetizzare le risposte agli utenti direttamente in cima alla pagina. Eppure, poco dopo il debutto, si sono verificati casi eclatanti di allucinazioni: in uno, l’IA suggeriva agli utenti di usare colla per attaccare il formaggio sulla pizza, facendo riferimento a un thread ironico su Reddit e questo ci fa capire che quando dice ai suoi utenti cosa pensare o fare, il bot attribuisce ai consigli di utenti anonimi di Reddit lo stesso peso delle pagine informative di organizzazioni governative, pubblicazioni di esperti, medici, storici, cuochi, tecnici, ecc.

Questi episodi non sono rari né casuali. Secondo esperti di IA e linguistica computazionale, la causa risiede nella natura stessa di come questi modelli vengono addestrati: i sistemi come ChatGPT o Gemini non ragionano nel senso umano del termine; prevedono la parola successiva in una sequenza di testo, basandosi su enormi quantità di dati testuali. Quando questi dati contengono errori, informazioni obsolete, o vengono interpretati in modo scorretto, il modello può “riempire i vuoti” con invenzioni che sembrano plausibili.

Ma perché una tecnologia così avanzata dovrebbe sbagliare proprio quando cerca di essere più utile? Gli sviluppatori stanno ancora cercando un equilibrio tra coerenza linguistica e affidabilità delle fonti, inoltre, i modelli tendono a fornire risposte anche quando non “sanno” davvero la risposta, perché sono progettati per essere conversazionali e proattivi.

Le conseguenze possono essere gravi

Un articolo del New York Times racconta come in ambito medico, trascrittori automatici come Whisper di OpenAI hanno prodotto documenti contenenti informazioni dannose o frasi del tutto inventate, mettendo potenzialmente a rischio pazienti e personale sanitario.

Per far fronte a questo fenomeno, le aziende tech stanno lavorando su diverse soluzioni. Una strategia nota come “grounding” prevede l’integrazione del modello con fonti esterne affidabili, come database in tempo reale o documentazione verificata mentre altri ricercatori propongono di allenare i modelli a riconoscere i propri limiti, imparando a rispondere con “non lo so” quando non ci sono dati certi, piuttosto che “indovinare”.

Tuttavia, la strada è ancora lunga.

Il CEO di OpenAI, Sam Altman, ha riconosciuto che le allucinazioni sono un problema “inerente ai modelli linguistici” e che probabilmente non scompariranno del tutto (fra l’altro ha tenuto recentemente a ribadire che non dovremmo fidarci di ChatGPT), altri studiosi sottolineano che il problema non è solo tecnico, ma culturale: in un’epoca di fiducia crescente nell’automazione, dobbiamo imparare a distinguere ciò che è generato artificialmente da ciò che è verificabile.

In definitiva, l’illusione della verità fornita dall’IA è una sfida cruciale per il futuro dell’informazione e della tecnologia e mentre i modelli diventano più sofisticati, anche gli utenti devono diventare più critici; affidarsi all’IA senza strumenti di verifica significa, in molti casi, esporsi al rischio di credere in una realtà alternativa — costruita, inconsapevolmente o no, da un algoritmo.

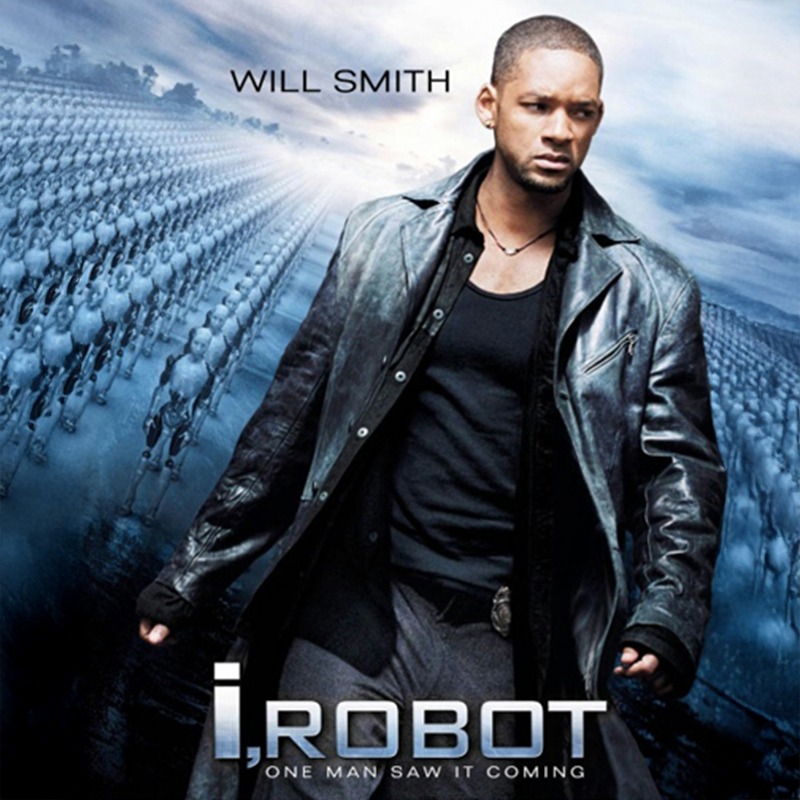

Io Robot

Immagini provenienti dal film sopra citato.